Stets auf der Suche nach dem Quell der Erkenntnis, haben wir diesmal einen Blick in die forschung geworfen, das Magazin der Deutschen Forschungsgemeinschaft (Heft 3-4/1999). Beeindruckt vom professionellen Layout, taten wir den einschlägigen Lehrbüchern den Gefallen und ließen unsere Augen zunächst auf die griffig-markanten Kernaussagen fallen. Größer und bunter als der normale Text und anscheinend von einigen lästigen Interpunktionsregeln befreit, darf ein solches ständiges Auf-den-Punkt-Bringen heute in keinem zeitgemäß (oder eben professionell) gesetzten Text mehr fehlen. Somit hat sich auch hier die Erkenntnis durchgesetzt, dass derartige Ergüsse wohl eh nur zum Nicht-gelesen-Werden erdacht und geschrieben werden. Oder sollten die prägnanten Kernsätze gar wirklich als Appetithäppchen gedacht sein, sollen sie der sich stetig verknappenden Ressource Zeit zum Trotz Lust auf den Konsum des ganzen Artikels machen?

Schauen wir sie uns dazu an, die Quintessenzen der Forschung der DFG. Wir lesen auf Seite 13: "Das rasche Wachstum des Marktes lässt neben verbesserten auch völlig neue Produkte erwarten". Hat da nicht der freundliche Broker in n-tv jüngst neben Plattitüden zu Zinsängsten und Kurs-Gewinn-Verhältnissen Ähnliches von sich gegeben? Doch nicht nur ökonomisch Sensationelles wird geboten. Auf Seite 17 lernen wir, dass "bei der Leistungsaddition die Leistung vieler Halbleiterquellen summiert und -zum Beispiel- einem Stecker zugeführt wird". Hier wird auf höchst anschauliche Weise klar, wie wichtig doch eine solide mathematische Grundausbildung gerade für die Ingenieurwissenschaften ist. Zwei Seiten später wird noch eins draufgesetzt: "Ein Summierprinzip, das bei jeder Frequenz mit gleichem Erfolg eingesetzt werden kann" - atemberaubend, und ohne interdisziplinäre Anstrengungen undenkbar. Nur zu gerne würden wir uns zu Addition und Mobilfunk eingehender weiterbilden, doch es gilt auch noch den schönen deutschen Wald zu besingen. Und Wissenswertes darüber zu erfahren, etwa auf Seite 22: "Waldbesitzer, Förster, Imker oder Mountainbiker sehen den Wald als Nutz- und Bewegungsraum unterschiedlich". Das ist völlig neu: Ich hielt Mountainbiker immer für die schnelle Eingreiftruppe des Forstamts, sozusagen für Lifestyle-Ausgaben des waidmännisch besorgten Ökobauern - stets bemüht, alte und kranke Pflanzen plattzumachen, um so neues Leben zu ermöglichen. Aber so kann man sich irren. Im Wald-Beitrag lohnt es sich übrigens, auch einmal die eine oder andere Bildunterschrift näher zu betrachten, kommt nun doch endlich auch der Wandersmann auf seine Kosten: "Weggabelungen dienen als Orientierungshilfe", so die prägnante Zusammenfassung langjähriger Waldforschungen auf Seite 23. Wohl noch nichts vom Wirtshaus im Spessart gehört, wie?

Doch auch die Festansprachen auf der DFG-Jahresversammlung 1999, in einem - der Bedeutung angemessen - mauve getönten "Exkurs" teilweise gekürzt abgedruckt, werden Opfer der inhaltlichen Verdichtung. "Die DFG lebt aus der Qualität der Ideen ihrer Antragsteller" lesen wir da, oder "Vorschläge zur Sicherung guter wissenschaftlicher Praxis werden Schritt um Schritt umgesetzt" - Sorgen um die Zukunft des Wissenschaftsstandorts Deutschland sind demnach fehl am Platze. Und alles gipfelt in der einen zentralen und geradezu existenziellen Frage: "Kann der Ertrag an Exzellenz und Qualität noch verbessert werden?" Ziemlich verwirrt suchen wir Rat bei Bertelsmann und finden unter "Exzellenz": früher Titel von hohen Beamten, heute noch von Botschaftern und Gesandten. Will die DFG etwa das diplomatische Korps erweitern?

Genug davon, schließlich gibt es auch noch anderes zu berichten. Roland Bulirschs Einzug in die Science-Fiction-Literatur etwa (siehe nachfolgenden Bericht), oder die Bemühungen um die Einrichtung eines interdisziplinären Master-Studiengangs Scientific Computing bzw. Computational Science and Engineering an der TUM (ebenfalls in diesem Quartl) und die Reaktionen, die diese Initiative (allein bisher) ausgelöst hat. Da ist zunächst die Informatik, die den Bezeichner Scientific Computing, weil eine zu große semantische Nähe zu Computer Science andeutend, hinterfragt, um sich dann wieder einer ihrer Lieblingsbeschäftigungen zuzuwenden, der Suche nach Alternativen zum ungeliebten Bezeichner Computer Science. Oder die Mathematik, die zwar grundsätzlich alles selber am besten kann, sich dann aber aus Belastungsgründen doch nur selten dazu in der Lage sieht. Ganz zu schweigen vom Chemiker, für den - Überraschung - die Chemie zu schwach repräsentiert ist. Insgesamt hat der Typus der Das-ist-ein-ganz-toller-Vorschlag-aber-Reaktion überwogen. Die Karawane zieht dennoch weiter.

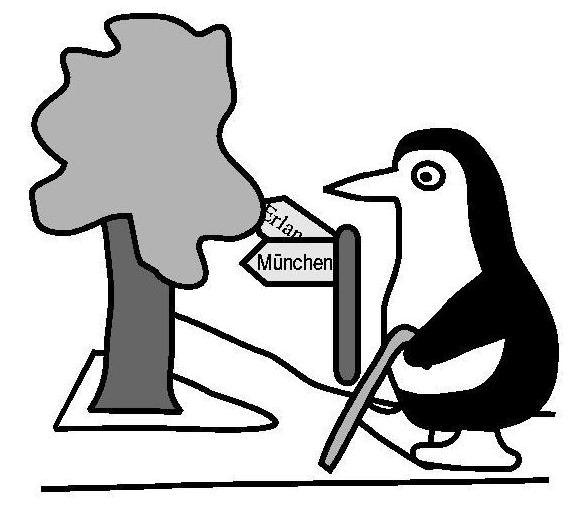

Diese Daten werden üblicherweise gewonnen, indem zunächst aus einer Analyse des zu betrachtenden Prozesses ein Reaktionsmechanismus extrahiert wird. Die hier benötigten reaktionskinetischen Parameter werden aus zumeist im Labormaßstab realisierten Experimenten ermittelt. Deren Interpretation ist vielfach problematisch, da sie lediglich auf einer Analyse der integralen Umsatzbilanz beruht und vereinfachende Annahmen bezüglich lokaler Parameter, z.B. Temperatur-, Geschwindigkeits- und Druckverteilung, voraussetzt. Dies ist in einem realen Reaktor nicht der Fall, wie in Abb. 1 anhand der Darstellung von Temperatur und Speziesverteilungen erkennbar ist.

Für einen "scale-up" der im Labormaßstab gewonnenen Ergebnisse zur Beschreibung einer großtechnischen Anlage erweist es sich als problematisch, dass diese Daten nicht die tatsächliche Kinetik wiedergeben, sondern durch obige Inhomogenitäten belastet sind. Insbesondere erweist sich die bei der Auswertung der Experimente angenommene Eindimensionalität der Strömung als große Fehlerquelle. Am LSTM-Erlangen konnte in Zusammenarbeit mit dem Lehrstuhl für Technische Chemie I der FAU Erlangen nun eine Methodik entwickelt werden, mit Hilfe mehrdimensionaler Reaktorsimulationen auf Basis der experimentell gewonnenen Daten zu verlässlicheren Reaktionsmechanismen zu gelangen. Dies konnte am Beispiel der Natrium-katalysierten Dehydrierung von Methanol gezeigt werden. Der Ansatz beruht im Wesentlichen auf der Idee, die Vorgänge im Modellreaktor mittels einer genauen numerischen Simulation der relevanten Transportvorgänge und Reaktionen detailliert zu simulieren. Damit kann das Systemverhalten des Modellreaktors bestimmt und bei der Analyse des Mechanismus zur Elimination von Fehlern zu berücksichtigt werden.

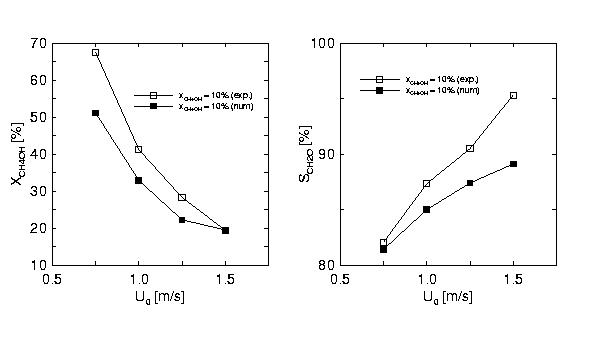

Die Simulation basiert im ersten Schritt auf experimentell gewonnenen Reaktionsdaten. Zur Anwendung kommt ein Finite-Volumen-Verfahren zur Lösung der inkompressiblen Navier-Stokes Gleichungen für reaktive Strömungen. Mittels einer Sensitivitätsanalyse wurden anschließend diejenigen Reaktionen bestimmt, die für verschiedene Betriebsparameter einen nennenswerten Einfluss auf den Methanol-Umsatzgrad und die Formaldehyd-Selektivität haben. Für diese Reaktionen wurden durch gezielte Parametervariationen die Reaktionsdaten optimiert, so dass die numerisch ermittelte Selektivität und der Umsatzgrad genau mit den im Experiment gewonnenen Daten übereinstimmen. Die Validität der neu bestimmten Daten wurde überprüft, indem dieser Prozess für mehrere verschiedene Betriebsparameter verglichen wurde. In Abb. 2 sind exemplarisch die Selektivität und der Umsatzgrad aus numerischer Simulation im Vergleich zum Experiment dargestellt.

Die nachträgliche Fehlerkorrektur durch Vergleich von Experiment und

Simulation setzt auch bei diesem Ansatz nach wie vor voraus, dass der

Reaktionsmechanismus selbst bekannt ist. Die Analyse setzt detaillierte

Kenntnisse der Reaktionskinetik voraus. Es zeigt sich allerdings, wie die

Erfahrungen der Reaktionskinetik zusammen mit numerischen Verfahren zur

Strömungssimulation genutzt werden können, um einen Beitrag zur besseren

Beschreibung sensitiver Reaktionsdaten zu leisten.

Worum es sich handelt? Nun, wohl erkennbar um einen Thriller mit leichtem bis mittlerem Science Fiction Einschlag, genauer um das Buch Nemesis von Bill Napier, einem weltweit renommierten Asteroidenforscher mit eigenem Kometen (Napier 7096). 1998 in den USA erschienen, zum Bestseller avanciert und natürlich flugs ins Deutsche übersetzt, lässt das Buch bis hierher einen Bezug zum FORTWIHR vermissen. Doch schmökern wir weiter. Die Spuren von Nemesis führen zurück ins 17. Jahrhundert, zu den Aufzeichnungen eines Mönches namens Vincenzi, der für seine wissenschaftlichen Überzeugungen auf dem Scheiterhaufen starb. Eine abenteuerliche Suche nach dem Original beginnt, mit Städten wie Oxford und Rom als Stationen (warum eigentlich nicht Castrop-Rauxel oder Großdingharting?). Wer das Rätsel entschlüsselt? Ein (natürlich exzentrischer) britischer Astronom. Ganz in 007-Tradition erhält so das Good Old Empire die Gelegenheit, die Neue Welt zu retten. Als die alten Beobachtungsdaten gefunden sind, muss die Trajektorie zur gegenwärtigen Position des Asteroiden berechnet werden - schnell und mit höchster Genauigkeit. Denn inzwischen geht es ja nicht mehr um Tage, sondern um wenige Stunden.

Und - bingo! - hier kommt der FORTWIHR ins Spiel, in Ost und West als Quell numerischer Verfahren der höchst schnellen und präzisen Art bekannt: Benutzt wird eine Weiterentwicklung eines Verfahrens von R. Bulirsch und J. Stoer. Doch es bleibt nicht bei der Erwähnung - ganz nebenbei erfährt der Leser auch etwas über die Bedeutung der Zeitschrittweite bei der numerischen Lösung gewöhnlicher Differentialgleichungen: "Jeder Schritt erfordert seine eigene Berechnungszeit. Je größer die Schrittlänge, desto weniger Schritte werden insgesamt benötigt, und desto schneller ist die Umlaufbahn berechnet. Lange Schritte sparen zwar Zeit, liefern aber auch unzuverlässige Resultate." Denn offenkundig gilt: "Kein richtiger Asteroid hat sich je in einer Folge gerader Linien bewegt."

Und am Ende: Die USA gibt's immer noch (alles andere wäre angesichts des eingesetzten Verfahrens auch eine Frechheit gewesen), und der russische Präsident Schirinowksi (!) meldet sich per Fernschreiber (!). Mehr wird aber nicht verraten.

Kommentar des zitierten und diesmal ganz unverhofft zu Ruhm

gekommenen FORTWIHR-Vorstands: "Es ist schon eigenartig,

dass die "die USA rettende Bahn" nach einer Methode berechnet

wird, die vor etwa 30 Jahren, ein paar Meter von Ihrem jetzigen

Dienstzimmer entfernt, ausgeknobelt wurde."

Eine detailaufgelöste numerische Simulation solcher Strömungen ist mit herkömmlichen CFD-Verfahren aufgrund der Komplexität der Geometrie oft nicht durchzuführen. Daher wurden und werden in der Regel Modellansätze verwendet, die auf einer Homogenisierung beruhen und somit keine lokalen Informationen über das Geschwindigkeitsfeld und die Druckverteilung mehr enthalten.

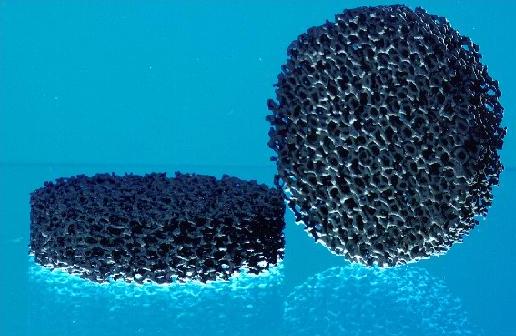

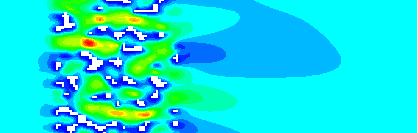

Mit den Lattice-Boltzmann-Verfahren (LBV) steht eine neue Simulationstechnik zur Verfügung, die sich durch geringen Rechen- und Speicheraufwand je Gitterknoten auszeichnet. Daher kann die Geometrie auf großen kartesischen, äquidistanten Gittern (einige 107 Gitterknoten) nach der marker-and-cell Methode vollständig diskretisiert werden. Die Berechnung erfolgt direkt und ohne Zuhilfenahme von (experimentell bestimmten) effektiven Größen. Die Geometriedaten lassen sich semi-automatisch aus 3D-Computertomographie oder CAD-Daten gewinnen. In Abb. 1 ist als Beispiel eine poröse SiC-Struktur dargestellt, wie sie in der Porenbrennertechnik verwendet wird. Das berechnete Strömungsfeld ist in Abb. 2 zu sehen, wobei der Strömungsverlauf durch sog. Streamribbons gekennzeichnet ist, die mit dem Druck eingefärbt sind.

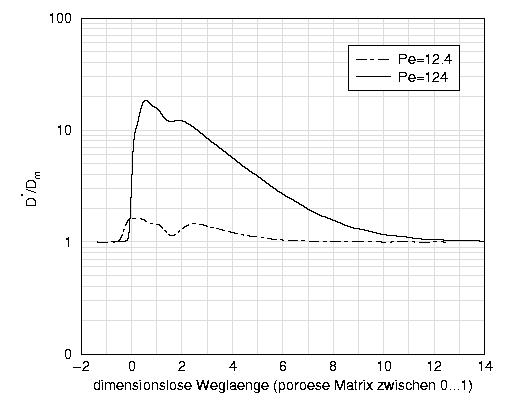

Mit Hilfe der LBV lassen sich neben der reinen Strömungsberechnung auch komplexe Transportvorgänge, z.B. hydrodynamische Dispersion und Diffusion, exakter als dies bisher in komplexen Geometrien möglich war, analysieren und vorhersagen. Abb. 3 zeigt exemplarisch die Dispersion eines Tracerfluids beim Durchgang durch das poröse SiC-Medium. Deutlich zu erkennen ist dabei die unterschiedlich starke Korrelation der Konzentrationsinhomogenitäten mit dem Geschwindigkeitsfeld. Bei hohen molekularen Diffusionskonstanten (geringen Pécletzahlen) liegt eine relativ gleichmäßige Konzentrationsverteilung vor, während bei geringen molekularen Diffusionskoeffizienten starke lokale Unterschiede auftreten.

Re = 14)

Pe = 12.4)

Pe = 124)

Abb. 3: Geschwindigkeitsfeld (oben) und Konzentrationsverteilung in einem Schnitt parallel zur Hauptströmungsrichtung für zwei unterschiedliche Pécletzahlen (hohe molekulare Diffusion im mittleren Bild, geringe molekulare Diffusion in der unteren Abbildung)

Abb. 4 zeigt den quantitativen Verlauf des axialen Dispersionskoeffizienten normiert mit dem molekularen Diffusionskoeffizienten. Der axiale Dispersionskoeffizient ist dabei ein Maß für die durch das poröse Medium aufgeprägten Geschwindigkeitsfluktuationen und die damit verursachte Vermischung des Fluids.

Somit erschließen die LBV eine Vielzahl von bisher nur schwer zugänglichen Anwendungsbereichen einer detaillierten

Simulation.

Die Ergebnisse der

detaillierten Untersuchungen können dabei wichtige Beiträge für das

Verständnis der ablaufenden Prozesse liefern. Darüber hinaus können sie

dazu verwendet werden, um Daten für die Modellierung mit

Homogenisierungsansätzen zu extrahieren.

Die Zeit war reif: Schließlich hatte es sich der FORTWIHR stets auf die Fahnen geschrieben, das wissenschaftliche Rechnen und die numerische Simulation auch in die Lehre zu tragen (in Erlangen gibt es das Programm Computational Engineering ja schon seit geraumer Zeit), schließlich findet sich an der TUM sowohl im Grundlagen- als auch im Anwendungsbereich erhebliche diesbezügliche Kompetenz in einer nur selten anzutreffenden fachlichen Breite, die durch die bevorstehende Installation des Bundeshöchstleistungsrechners am LRZ und die damit verbundene Einrichtung des Kompetenznetzwerks für technisch-wissenschaftliches Hoch- und Höchstleistungsrechnen (KONWIHR) weitere Impulse erhalten wird. Demgegenüber fehlt in zunehmendem Maße qualifizierter und geeignet ausgebildeter Nachwuchs: Noch immer kommen die Simulationsexperten nahezu ausschließlich aus den Einzeldisziplinen Mathematik, Informatik, Ingenieur- bzw. Naturwissenschaften. In der Praxis führt dies oft zu Defiziten, weil die notwendigen Grundlagen aus den übrigen Fachdisziplinen i.A. im Selbststudium nicht adäquat nachgeholt werden können.

Das nun von H.-J. Bungartz und C. Zenger vorgelegte Master-Programm Computational Science and Engineering soll diesem Mangel abhelfen. Aufbauend auf einem Bachelor-Abschluss in einem ingenieur- oder naturwissenschaftlichen Fach, werden in vier Fachsemestern die notwendigen Grundlagen in Mathematik und Informatik sowie die erforderlichen Spezialkenntnisse im wissenschaftlichen Rechnen und exemplarisch in zwei Anwendungsdisziplinen vermittelt. Im Unterschied zur Fokussierung auf die numerische Simulation in einer Fachdisziplin soll Computational Science and Engineering breiter angelegt sein und seine Schwerpunkte auf den Erwerb übergeordneter und grundlegender Kenntnisse und Fertigkeiten aus Mathematik und Informatik legen, die für ein rechnergestütztes Vorgehen in zahlreichen Anwendungsfeldern relevant sind. Deshalb schließt das Programm ein breites und ergänzbares Spektrum von Anwendungsgebieten ein, woraus die Studierenden wenigstens zwei näher kennen lernen sollen. Ein Industriepraktikum zwischen dem ersten und zweiten Studienjahr soll zudem Einblicke in die industrielle Praxis vermitteln.

Auch in anderer Hinsicht wird Neuland betreten: In Anlehnung an den Netzwerkgedanken des FORTWIHR sowie des KONWIHR sieht das Konzept vor, dass einzelne Module auch von Instituten anderer Universitäten eingebracht werden können und insbesondere die Master's Thesis dort angefertigt werden kann. Verbindliche Bereitschaftserklärungen liegen vor von Lehrstühlen an den Universitäten Augsburg, Erlangen-Nürnberg, Würzburg, Tübingen und Stuttgart. Zur praktischen Realisierung sollen die Möglichkeiten der Virtuellen Hochschule Bayern mit einbezogen und die entsprechenden Veranstaltungen über Netz zugänglich gemacht werden.

Computational Science and Engineering ist von der Sache her

transdisziplinär und keiner einzelnen Fakultät zuzuordnen. Deshalb soll

der Studiengang von den beteiligten Fakultäten für Informatik, Mathematik,

Elektrotechnik und Informationstechnik, Maschinenwesen, Bauingenieur- und

Vermessungswesen, Physik sowie Chemie gemeinsam getragen werden, unter

formaler Federführung der Informatik. Deren Fachbereichsrat hat das Konzept

jüngst verabschiedet, die erste Hürde ist genommen.

Zur Physikalischen Fakultät der West Universität in Timisoara, Rumänien, bestehen dabei besonders gute Kontakte, nicht zuletzt aufgrund regelmäßiger gegenseitiger Besuche von Studenten und Dozenten im Rahmen eines ERASMUS-Austauschprogramms. Nach einem einjährigen Aufenthalt über den DAAD sowie mehreren mehrmonatigen Besuchen in den letzten Jahren ist Dr. Daniel Vizman aus Timisoara, diesmal als Humboldt-Stipendiat, seit Oktober 1999 erneut für ein Jahr zu Gast in Erlangen.

Im Rahmen seiner Aufenthalte hatte Dr. Vizman entscheidenden Anteil an der Entwicklung des CGL-eigenen Programms STHAMAS3D zur numerischen Simulation dreidimensionaler, zeitabhängiger Strömungen. Von besonderem Interesse sind am CGL Strömungen in Halbleiter- und Metallschmelzen, wie sie bei der Halbleiterkristallzüchtung bzw. bei Gießprozessen auftreten. Ein Schwerpunkt von Dr. Vizmans Arbeiten ist dabei die Untersuchung des Einflusses von stationären und zeitabhängigen magnetischen Feldern auf die Strömungen in den elektrisch leitfähigen Schmelzen. Dazu sind in STHAMAS3D verschiedene Magnetfeldmodelle zur Beschreibung der Magnetohydrodynamik vorhanden.

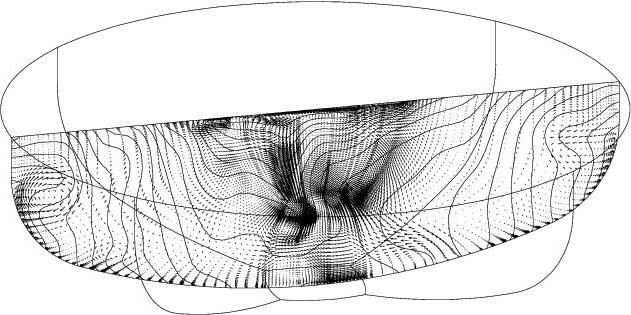

Ein weiteres Hauptaugenmerk gilt dem Czochralski-Verfahren zur Züchtung von Silizium-Einkristallen. Hierbei befindet sich die Silizium-Schmelze in einem Quarztiegel. In der Mitte der freien Oberfläche der Schmelze wird ein Kristallkeim angesetzt, und der wachsende Kristall wird unter Drehung von Kristall und Tiegel nach oben aus der Schmelze gezogen. Die thermischen Verhältnisse im Kristall-Schmelze-Tiegel Bereich resultieren meist in heftiger, teils turbulenter Auftriebskonvektion, welche entscheidenden, in der Regel negativen Einfluss auf die Qualität des gezüchteten Halbleitermaterials hat. Diese unerwünschten Effekte versucht man zum Beispiel durch die Kristall- und Tiegeldrehung oder die Anwendung von Magnetfeldern zu kompensieren. Die resultierende Strömung wird also von vielen Parametern beeinflusst und erweist sich meist als sehr kompliziert. Eine numerische Simulation der Strömung in der Czochralski-Schmelze bietet sich zur Optimierung der Züchtungsprozesse natürlich an, gerade im Hinblick auf Paramtervariationen. Da Turbulenzmodelle für das vorliegende Problem versagen, bleibt nur die Direkte Numerische Simulation. Dies impliziert aufgrund der nötigen räumlichen und zeitlichen Auflösung (die Durchmesser industrieller Tiegel bewegen sich im Bereich von 35 bis 80 cm) einen enormen Bedarf an Rechen- und Speicherkapazität. Die Nutzung von Hoch- oder besser Höchstleistungsrechnern, zum Beispiel am LRZ München, ist hierbei unumgänglich. Abb. 1 zeigt mit dem Temperatur- und Geschwindigkeitsprofil in einer Silizium-Czochralski-Schmelze ein typisches Resultat von Dr. Vizmans Arbeit.

Die wirtschaftliche Bedeutung des Halbleitermaterials Silizium macht Dr. Vizmans Untersuchungen am CGL zu einem überaus aktuellen Forschungsthema. Ein Gewinn für das CGL ist es allemal, wenn Dr. Vizman die 20-stündige Busfahrt aus dem Westen Rumäniens nach Erlangen auf sich nimmt.

Einen deutlich kürzeren Anfahrtsweg hat Prof. Yvonne Stry. Vom Beginn des

Sommersemesters 1999 an verbrachte die Nürnberger Fachhochschul-Professorin

ein "Praxissemester" am CGL. Sie

nutzte die Zeit, um in das Simulationswerkzeug CrysVUn++, das in der

Arbeitsgruppe von Prof. Müller im Rahmen des FORTWIHR zur Simulation des

globalen Wärmetransports in Kristallzüchtungsanlagen entwickelt wurde,

laminare Konvektion zu implementieren. Die Dimension des Problems wurde durch

Annahme von Zylindersymmetrie reduziert, die Berechnungen erfolgen daher in

Zylinderkoordinaten. Sie wählte zur Diskretisierung der stationären

Navier-Stokes-Gleichungen die Finite-Volumen-Methode auf unstrukturierten

Gittern. Hierbei wird für das Geschwindigkeitsfeld ein quadratischer und

für den Druck ein linearer Ansatz verwendet. Der Navier-Stokes-Löser

basiert auf einem algebraischen SIMPLE-Algorithmus. Ziel ist es, laminaren

Energie- und Stofftransport durch Konvektion in Schmelze und Gasraum

zu simulieren. Das CGL führt die Arbeiten von Frau Prof. Stry

insbesondere in Richtung Stofftransport weiter. Die sich dabei engagierenden

Mitarbeiter werden weiter tatkräftig von Frau Stry unterstützt, da sie

den guten Kontakt zum CGL auch nach dem offiziellen Ende ihres

Gastaufenthaltes aufrecht erhält.

Die insg. 9 Millionen Mark werden aus Mitteln der Hi-Tech-Offensive Bayern aufgebracht und zielen darauf ab, für einen Zeitraum von zunächst vier Jahren "auf dem Gebiet des technisch-wissenschaftlichen Hochleistungsrechnens anwendungsorientierte Grundlagenarbeiten bis hin zu konkreten Anwendungen durchzuführen und dabei insbesondere die Nutzung von Hoch- und Höchstleistungsrechnern, vornehmlich des Höchstleistungsrechners in Bayern (HLRB) am LRZ, nachhaltig zu stützen". Damit folgt der Freistaat Bayern der Vorgabe des Wissenschaftsrats, im Umfeld der Bundeshöchstleistungsrechner ein Kompetenzzentrum bzw. -netzwerk zur Nutzbarmachung der Rechenleistung sowie zur Bereitstellung von Dienstleistungs- und Service-Angeboten aufzubauen. Anträge können ab sofort an die Geschäftsstellen des KONWIHR in München oder Erlangen gerichtet werden. Für nähere Informationen hierzu sowie zum KONWIHR allgemein sei auf die Homepage http://konwihr.in.tum.de/ verwiesen.

Und der Bundesrechner selbst? Platz ist im LRZ für den 23 Tonnen schweren,

610kW Leistung erfordernden (was u.a. zehn Umluftgeräte sowie zwei 6

Tonnen schwere Umwälzer nach sich zieht) und 72qm Standfläche fressenden

Giganten schon seit geraumer Zeit gemacht. Als Vorgeschmack ist eine kleine

Version der Hitachi SR8000F1, von den Mitarbeitern liebevoll "Baby-Hitachi"

genannt, zu Test- und Portierungszwecken bereits im Einsatz, und

wenn Sie dieses Quartl in Händen halten, werden schon die ersten Teile des

heiß erkämpften und lang ersehnten Rechners aufgestellt und installiert

sein.

Der Kontakt war anlässlich der Autumn Academy in Ohrid (Mazedonien)

im vergangenen Oktober entstanden (wir berichteten, siehe Quartl-Ausgabe

4/99). Jetzt sollten eine Fortführung der Sommerschulaktivitäten

sowie weitere Kooperationsmöglichkeiten - insgesamt oder bilateral -

diskutiert werden. Das umfangreiche Besuchsprogramm, von Frau Dr.

D. Melling vom LSTM in gewohnt perfekter Manier zusammengestellt und

von Eingeweihten auch als "much more than appropriate" bezeichnet,

sah Besichtigungen an den Universitäten Erlangen-Nürnberg, Bayreuth und

Augsburg, an der TU München sowie beim Bayerischen Staatsministerium

für Wissenschaft, Forschung und Kunst vor. An der TUM wurden den Gästen

nach einem Informationsgespräch mit dem Vizepräsidenten Prof. Bode der

Flugsimulator am Lehrstuhl für Flugmechanik und Flugregelung (Prof. Sachs),

der Forschungsreaktor FRM-1 (samt Baustelle des Nachfolgers), die

Hochleistungsrechner am LRZ (einschließlich des freien Platzes für die

neue Hitachi) sowie ausgewählte Beispiele aus dem Forschungs- und Lehrprogramm

am Lehrstuhl für Informatik V (Prof. Zenger, Dr. Bungartz) vorgeführt.

Erschöpft und beeindruckt zeigten sich die Delegationsmitglieder am

Ende der Woche, die mit einem gemeinsamen Abendessen im Münchener

Löwenbräukeller ausklang.

FORTWIHR Intern

FORTWIHR Gäste

Bitte notieren:

| Ferienakademie 2000 | |

| Das diesjährige Programm der Ferienakademie der Universität Erlangen-Nürnberg und der TU München im Sarntal (17.9. bis 29.9.2000) besticht nicht zuletzt durch eine Verdoppelung der Zahl der Dozenten aus dem FORTWIHR gegenüber dem Vorjahr - ein zuverlässigeres Qualitätssiegel ist kaum noch denkbar! | |

| 1 | Formale Modelle von Programmiersprachen |

| Prof. T. Nipkow (TUM), Prof. H.-J. Schneider (FAU) | |

| 2 | Dienstgüte und Sicherheit in modernen Kommunikationssystemen |

| Prof. H.-G. Hegering (TUM), Prof. U. Herzog (FAU) | |

| 3 | Angewandte Physik |

| Prof. F. Koch (TUM), Prof. M. Schulz (FAU) | |

| 4 | Numerische Methoden und geometrische Modellbildung in der Strukturmechanik |

| Prof. G. Kuhn (FAU), Prof. E. Rank (TUM) | |

| 5 | Katalyse in Forschung und Anwendung |

| Prof. G. Emig (FAU), Prof. J. A. Lercher (TUM) | |

| 6 | Nanotechnologie: Experimentelle und mathematische Methoden |

| Prof. K.-H. Hoffmann (TUM), Prof. G. Müller (FAU) | |

| 7 | Optische Kommunikationsnetze für das Breitband-Internet |

| Prof. J. Eberspächer (TUM), Prof. J. Huber (FAU) | |

| 8 | Halbleiterelektronik und Mikromechatronik: Physikalische Grundlagen und Modellierung |

| Prof. G. Döhler (FAU), Prof. G. Wachutka (TUM) | |

| 9 | Numerische Methoden der Strömungsmechanik |

| Prof. F. Durst (FAU), Prof. Chr. Zenger (TUM) | |

| 10 | Innovationen der molekularen Medizin und klinische Fallpräsentationen |

| Prof. B. Gänsbacher (TUM), Prof. A. Steinkasserer (FAU) | |

|

Anmeldeformulare und nähere Informationen gibt es hier: http://www5.in.tum.de/FA/ | |